Pergunta

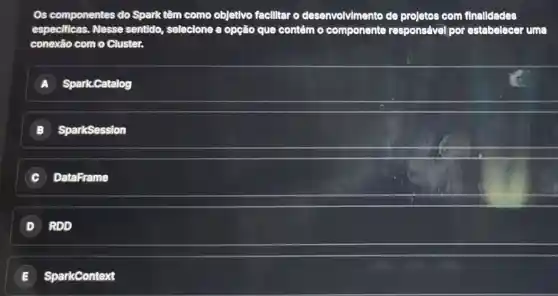

Os componentes do Spark têm como objetivo facilltar o desenvolvimento de prole tos com filn alldades especificas. Nesse sentido, selecione a opção que contém o componente responsáv vel por e stabe lecer un là conexão com 0 Cluster. A Spark.Catalog SparkSession DataFrame RDD E ) SparkContext

Solução

Verification of experts

Verification of experts4.6202 Voting

RodrigoEspecialista · Tutor por 3 anos

Responder

opção correta é a letra E) SparkContext. O SparkContext é o componente responsável por estabelecer a conexão com o cluster no Apache Spark. Ele é usado para criar RDDs (Resilient Distributed Datasets) e para interagir com o cluster, como enviar tarefas para os trabalhadores e gerenciar a memória.

Clique para avaliar: